Wat zijn benchmarktests voor software?

Er zit een verschil in software aanmaken die werkt en software maken die goed werkt. Om ervoor te zorgen dat software in de laatste categorie valt, geven ontwikkelaars over het algemeen de voorkeur aan benchmarktests.

Deze methode onderscheidt zich van de verschillende soorten softwaretests om vast te stellen waar een project staat ten opzichte van concurrerende oplossingen en welke aspecten verbeterd moeten worden.

In dit artikel wordt uitgelegd hoe benchmarktests dat bereiken, hoe ze ervoor zorgen dat softwaretoepassingen voldoen aan de prestatieverwachtingen en met welke best practices rekening moet worden gehouden bij de implementatie van de techniek.

Inzicht in benchmarktests voor software

What is automated testing?

Bij benchmarktests voor software worden de prestaties van een softwaretoepassing vergeleken met een vooraf gedefinieerde set standaarden of benchmarks. Dit is anders dan standaardprestatietests, die enkel bedoeld zijn om te verifiëren dat de software voldoet aan de functionele basisvereisten.

Benchmarks kunnen bestaan uit industriestandaarden, vooraf afgesproken interne doelen of zelfs de prestaties van toepassingen van concurrenten. Deze vergelijkingen stellen softwareontwikkelingsteams in staat om verbeterpunten te identificeren en ervoor te zorgen dat de software voldoet aan de gewenste kwaliteitsnormen.

Het doel is om een objectieve maatstaf voor de prestaties te bieden, zodat ontwikkelaars begrijpen hoe de software zich gedraagt onder verschillende omstandigheden. Door op deze manier fouten en mogelijke knelpunten te identificeren, heb je de eerste stap op weg naar een naadloze gebruikerservaring gemaakt.

Typen benchmarktests voor software

Toen handmatig testen de norm was, was het gebruikelijk dat softwarebedrijven een voltijds QA-team in dienst hadden. Dit team ontwikkelde een verzameling 'testplannen' of stapsgewijze checklists die bevestigen dat een kenmerk van een softwareproject zich gedraagt zoals verwacht. Het QA-team voerde deze checklists vervolgens telkens handmatig uit wanneer er een nieuwe update of wijziging in het softwareproject werd doorgevoerd, en stuurde de resultaten van de testplannen vervolgens terug aan het technische team voor beoordeling en eventuele verdere ontwikkeling om problemen op te lossen.

Dit proces was traag, duur en foutgevoelig. Geautomatiseerd testen levert enorme voordelen op voor de efficiëntie van het team en de ROI van de QA-teams.

Geautomatiseerd testen legt de eigendomsverantwoordelijkheid in handen van het technische team. De testplannen worden ontwikkeld in combinatie met de reguliere ontwikkeling van functies in de roadmap en worden vervolgens automatisch uitgevoerd met behulp van tools voor continue integratie van software. Geautomatiseerd testen bevordert de omvang van het lean QA-team en stelt het QA-team in staat om zich te richten op gevoeligere functies.

Ontwikkelaars kunnen verschillende benchmarks overwegen voor het meten van de softwareprestaties tijdens de ontwikkeling, afhankelijk van de functionaliteit die ze het meest willen perfectioneren. Laten we eens kijken naar de vier meest voorkomende gebieden voor benchmarktests:

Prestatiebenchmarks

Prestatiebenchmarktests meten de snelheid en efficiëntie van een softwaretoepassing in typische gebruiksscenario's. Door scenario's uit de praktijk en gebruikersinteracties te simuleren, kunnen ontwikkelaars waardevolle gegevens verzamelen over responstijden, verwerkingssnelheden van transacties en het gebruik van middelen (CPU, geheugen, disk I/O). Deze informatie helpt om de gebieden vast te stellen waar code-optimalisatie of hardware-upgrades nodig zijn om prestatieproblemen op te lossen.

Belastingsbenchmarks

Belastingsbenchmarks beoordelen hoe de software presteert bij verschillende gebruikersbelastingen. Door verschillende gelijktijdige gebruikers te simuleren, kunnen ontwikkelaars knelpunten in de prestaties identificeren die kunnen ontstaan wanneer de toepassing de maximale capaciteit heeft. Dit is cruciaal voor toepassingen die veel verkeer verwachten of seizoenspieken ervaren tijdens het gebruik. Het analyseren van statistieken zoals responstijden, foutenpercentages en doorvoer onder verschillende belastingsomstandigheden helpt ervoor te zorgen dat de software aan de verwachte gebruikersvraag kan voldoen.

Oplossing bekijken

Software bouwen en gebruiken met Open DevOps

Gerelateerd materiaal

Geautomatiseerd testen in DevOps

Stressbenchmarks

Stressbenchmarks gaan een stapje verder dan belastingtests door de software opzettelijk boven de normale bedrijfscapaciteit te drijven. Dit helpt om het breekpunt van de toepassing te ontdekken en te beoordelen of het in staat is om op een soepele manier te herstellen na een onderbreking. Door vast te stellen hoe het systeem zich onder extreme omstandigheden gedraagt, kunnen ontwikkelaars maatregelen nemen om de stabiliteit te verbeteren en catastrofale onderbrekingen in productieomgevingen te voorkomen.

Schaalbaarheidsbenchmarks

Waar belastingbenchmarktests het gedrag van de software onder specifieke omstandigheden test, evalueren schaalbaarheidsbenchmarks de mogelijkheid om tussen die omstandigheden te schakelen. Dit kan betekenen dat het aantal gebruikers, het gegevensvolume of het transactievolume wordt verhoogd. Alle bedrijven willen groeien, en overheden moeten hun platforms voorbereiden op massale implementatie. Maar buiten die gebieden bestaan er nog veel andere toepassingen met een hoog groeipotentieel, zoals online multiplayer games, sociale netwerken en IOT-toepassingen.

Hoe werken benchmarktests voor software?

1. End-to-end-tests

Benchmarktests omvatten doorgaans de volgende stappen:

- Planning: definieer de doelstellingen van de test, identificeer belangrijke prestatie-indicatoren (KPI's) en stel de benchmarks vast. KPI's zijn anders dan benchmarks omdat het strikt interne maatstaven zijn voor hoe het team naar verwachting zal presteren.

- Opstelling van de testomgeving: creëer een gecontroleerde omgeving die lijkt op de productieomgeving. De productieomgeving is niet ideaal voor tests omdat het gaat om daadwerkelijke gebruikersgegevens die tijdens het testen onbedoeld kunnen worden gewijzigd of aan kwetsbaarheden kunnen worden blootgesteld.

- Uitvoering van de test: voer de benchmarktests uit met geschikte tools en verzamel prestatiegegevens. De keuze van de tools hangt af van de statistiek die wordt getest, zoals functionele, prestatie-, beveiligings- of bruikbaarheidscriteria.

- Analyse: analyseer de resultaten en vergelijk ze met de vastgestelde benchmarks.

- Rapportage: documenteer de bevindingen en deel ze met het ontwikkelingsteam.

Bij benchmarktests voor software wordt doorgaans gebruik gemaakt van tools zoals JMeter, LoadRunner en Gatling. De belangrijkste statistieken die tijdens deze tests worden verzameld, zijn onder meer responstijden, verwerkingssnelheid, foutpercentages en het gebruik van middelen.

Voordelen van benchmarktests voor software

Naast het algemene voordeel van het meten van prestaties, capaciteit en schaalbaarheid van software in ontwikkeling, bieden benchmarktests nog een aantal specifieke voordelen:

Garandeert de betrouwbaarheid van de software

Ontwikkelaars kunnen proactief potentiële problemen identificeren en aanpakken voordat ze gevolgen hebben voor gebruikers. Dit leidt tot verbeterde stabiliteit, minder downtime en een hogere gebruikerstevredenheid. Door regelmatig benchmarktests uit te voeren, zorg je ervoor dat er vertrouwen komt in het vermogen van de software om in de loop van de tijd consistent te presteren.

Identificeert knelpunten en prestatieproblemen

Benchmarktests kunnen helpen verborgen knelpunten in de prestaties aan het licht te brengen die misschien niet duidelijk zijn als het systeem of de componenten afzonderlijk worden getest. Dit komt omdat bij reguliere tests de juistheid belangrijker is dan de prestaties of efficiëntie. De knelpunten die benchmarktests aan het licht brengen, kunnen liggen in de code van de toepassing, databasequery's, netwerkinfrastructuur of hardwarebeperkingen. Door deze beperkingen te identificeren, kunnen ontwikkelaars de getroffen gebieden optimaliseren om de algemene systeemprestaties te verbeteren.

Biedt een basis voor toekomstige verbeteringen

De resultaten van benchmarktests dienen als een waardevolle basis voor het meten van de impact van toekomstige wijzigingen in de software. Wanneer nieuwe functies worden toegevoegd of de code wordt geoptimaliseerd, kunnen ontwikkelaars de nieuwe resultaten van de benchmark vergelijken met de basis om de impact van de wijzigingen te beoordelen. Dit zorgt ervoor dat updates en aanpassingen de prestaties verbeteren in plaats van per ongeluk nieuwe problemen te introduceren.

Best practices voor het uitvoeren van benchmarktests voor software

Benchmarktests richten zich op de goede functionaliteit van de software. Het is daarom ook de moeite waard om ervoor te zorgen dat de tests zelf goed worden uitgevoerd. Dit zijn enkele tips voor een succesvol benchmarktestproces:

- Definieer duidelijke doelstellingen: geef een duidelijk beeld van de doelen van de benchmarktests en de specifieke prestatiestatistieken die moeten worden gemeten.

- Gebruik geschikte tools: selecteer de juiste tools voor de taak en zorg ervoor dat ze correct zijn gekalibreerd en geconfigureerd voor de taak die moet worden uitgevoerd. Factoren zoals het type toepassing, de verwachte belasting en de gewenste statistieken zullen ook bepalen wat de beste tool is.

- Aandacht voor de testomgeving: zorg ervoor dat de testomgeving nauw aansluit bij de productieomgeving om nauwkeurige en betrouwbare resultaten te verkrijgen.

- Benchmarks regelmatig bijwerken: benchmarks moeten mee evolueren met de software. Werk de benchmarks regelmatig bij om veranderingen in de verwachtingen van gebruikers, industriestandaarden en technologische vooruitgang te reflecteren.

- Herhaal tests meerdere keren: herhaling brengt variaties in prestaties aan het licht en zorgt voor een meer representatieve dataset. Het is ook een goede gewoonte om tests uit te voeren onder verschillende omstandigheden (bijvoorbeeld bij verschillende gebruikersbelastingen, op verschillende tijdstippen) om te begrijpen hoe de prestaties veranderen.

- Nauwkeurige analyse van resultaten: door zorgvuldig de meest geschikte statistische methode te kiezen, de technieken voor het identificeren van correlaties te selecteren en nauwkeurige aandacht te hebben voor relevante factoren kun je de meest waardevolle inzichten vaststellen als leidraad voor inspanningen op het gebied van prestatieoptimalisatie. Dit is nog een geval van de juiste tools kiezen, zoals een webtoepassing voor geautomatiseerde gegevensanalyse en -rapportage, of tools om prestatietrends in de loop van de tijd te volgen.

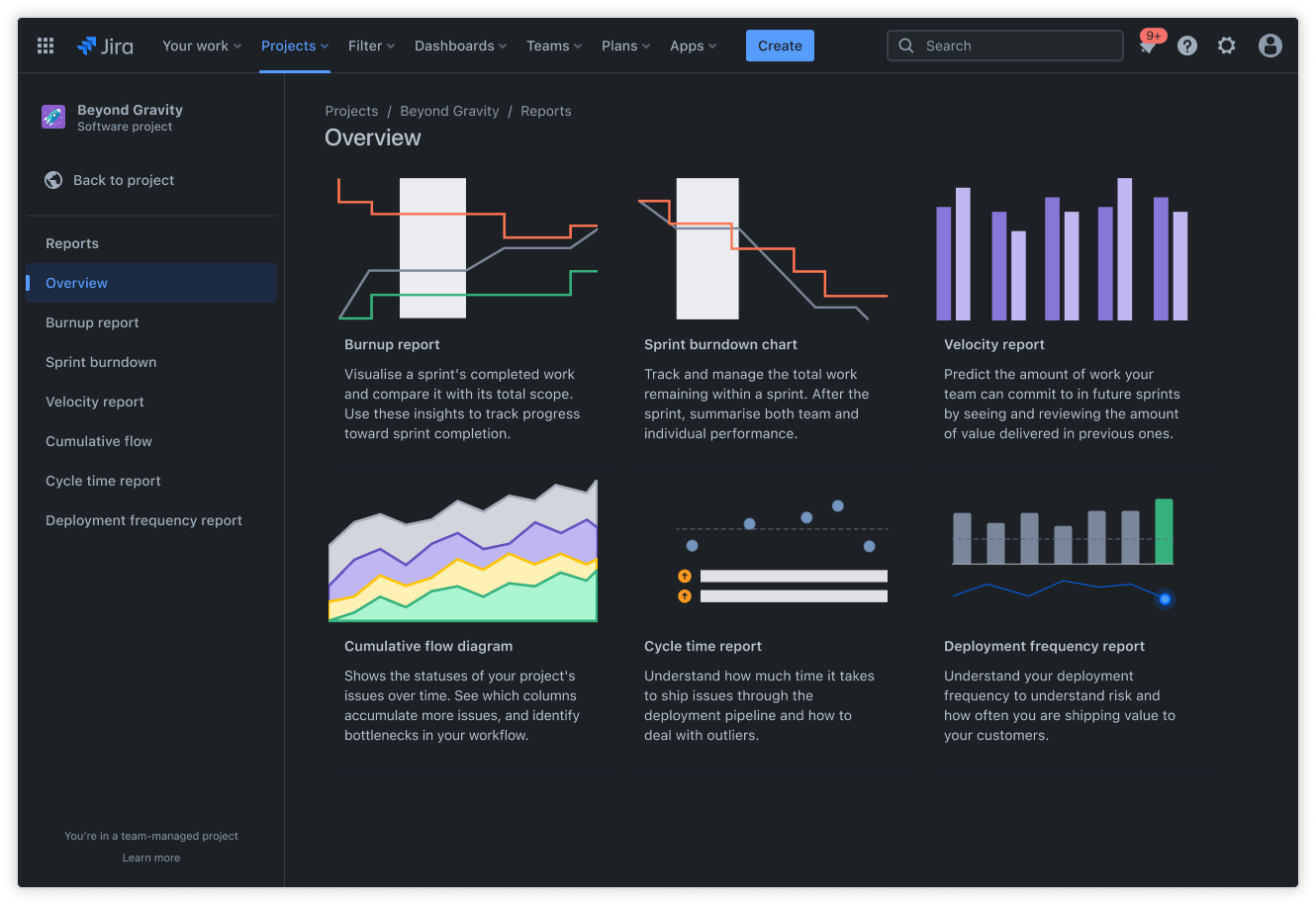

Een procesbeheerplatform zoals Jira kan een belangrijke rol spelen bij het beheren en bijhouden van benchmarktests, vooral als de productie geautomatiseerd is volgens een model voor Continue implementatie (CD). Dit zijn de functie waarmee Jira zich in dit opzicht onderscheidt:

Jira-backlog: gebruik de backlog om de activiteiten voor benchmarktests te plannen en te prioriteren, naast andere ontwikkelingstaken.

Jira-rapporten: gebruik de kant-en-klare rapporten van Jira om teams te helpen de voortgang van het project bij te houden, trends te visualiseren en toekomstige prestaties te voorspellen. Deze rapporten kunnen ook worden gebruikt om resultaten met belanghebbenden te delen.

Gebruik een gratis sjabloon voor een projectrapport

Door benchmarktests in Jira te integreren, kunnen teams ervoor zorgen dat prestatieoptimalisatie een integraal onderdeel is van het ontwikkelingsproces, wat leidt tot een betere softwarekwaliteit.

Veelvoorkomende uitdagingen bij benchmarktests voor software

De bovenstaande lijst van best practices benadrukt hoe belangrijk het is om voorzichtig te zijn bij het opzetten en beheren van een programma voor benchmarktests. Dit zijn enkele veelvoorkomende valkuilen bij benchmarktests voor software en hoe je daarmee om kunt gaan:

- Beperkingen van middelen: benchmarktests kunnen veel middelen vergen, zoals bijvoorbeeld hardware- en softwaremiddelen. Een voordeel van het gebruik van Jira is dat het ingebouwde software voor middelenbeheer biedt die teams helpt om de nodige middelen vrij te maken en toe te wijzen voor tests.

- Testgegevens onderhouden: het aanmaken en beheren van realistische testgegevens kan tijdrovend en uitdagend zijn. Ontwikkelaars kunnen tools voor het beheer van testgegevens (TDM) gebruiken om testgegevens te genereren, te maskeren en te beheren. Deze tools kunnen subsets van gegevens extraheren uit productiedatabases, maskering gebruiken om de privacy van gegevens te beschermen, of synthetische gegevens aanmaken die de statistische eigenschappen van de originele datasets nabootsen.

- Variabiliteit in testomgevingen: het kan complex zijn om de testomgeving op de productieomgeving af te stemmen, en kleine verschillen kunnen tot onnauwkeurige resultaten leiden. Jira biedt wederom een oplossing. Door een beheersysteem voor de testomgeving in Jira te maken, kunnen ontwikkelaars testomgevingen volgen en beheren, waardoor consistentie wordt gegarandeerd en de variabiliteit wordt beperkt.

Integreer benchmarksoftwaretests in Jira voor een betere softwareontwikkeling

Naast het gebruik van Jira voor specifieke taken, zoals resourcebeheer en testomgevingbeheer, heeft het platform verschillende functies die kunnen worden geïntegreerd in de testworkflow van benchmarks. Hier zijn enkele gebieden waar Jira-integratie kan helpen om het hele proces te stroomlijnen:

- Prestatietrends volgen: met de functies Werkitems en Aangepaste velden van Jira kunnen teams prestatiegerelateerde bugs, verbeteringen en taken signaleren en registreren. Dit zijn basisvereisten voor het bijhouden van prestatiestatistieken in de loop van de tijd, het identificeren van verbeterpunten, het volgen van de oplossing van afwijkingen en het meten van de impact van optimalisaties.

- Benchmarkactiviteiten beheren: in Jira kunnen teams Agile workflowplannen en Agile softwareontwikkelingsborden maken om prioriteiten te stellen en over te schakelen tussen specifieke fasen van het testproces voor benchmarks.

- Effectieve samenwerking: faciliteer de communicatie en samenwerking tussen ontwikkelaars, testers en belanghebbenden met betrekking tot prestatieproblemen en -verbeteringen. Een belangrijk aspect van deze functionaliteit is de mogelijkheid van Jira om aangepaste rapporten te genereren om prestatiegegevens te visualiseren, de voortgang bij te houden en bevindingen te communiceren. Tegelijkertijd koppelt de functie Werkitems meldingen van prestatietests aan gerelateerde ontwikkelingstaken, bugs of userstory's. De functie Bijlages maakt ook gebruik van gecentraliseerde toegang om resultaten van prestatietests, rapporten en analysedocumenten met relevante werkitems op te nemen.

- Backlog: de backlogstructuur van Jira is het waard om opnieuw te blijven gebruiken, omdat het makkelijker is om taken te taggen en prioriteiten te stellen bij benchmarktests. Door userstory's speciaal voor prestatietests te creëren, kunnen teams de functies van de backlog gebruiken voor gedetailleerde planning, het plannen van sprints en het bijhouden van de voortgang. Dit is vooral handig voor teams die graag iteratief werken, omdat ze alle taken in de backlog kunnen plannen en de scope van het project kunnen visualiseren.

Door gratis benchmarksoftwaretests te integreren in Jira, kunnen ontwikkelingsteams prestaties optimaliseren, wat leidt tot software van hogere kwaliteit, verbeterde gebruikerstevredenheid en een efficiënter ontwikkelingsproces.

Deel dit artikel

Volgend onderwerp

Aanbevolen artikelen

Bookmark deze resources voor meer informatie over soorten DevOps-teams of voor voortdurende updates over DevOps bij Atlassian.

DevOps-community

Blog lezen