Czym są testy porównawcze oprogramowania?

Istnieje różnica między tworzeniem oprogramowania, które działa, i takiego, które działa dobrze. Aby mieć pewność, że oprogramowanie należy do tej drugiej kategorii, programiści najczęściej sięgają po testy porównawcze.

Ta metodologia wyróżnia się spośród różnych typów testów oprogramowania, ponieważ pozwala określić, gdzie plasuje się projekt w stosunku do konkurencyjnych rozwiązań i które aspekty wymagają poprawy.

W tym artykule wyjaśnimy, jak testy porównawcze osiągają ten cel, jak pomagają zagwarantować, że aplikacje spełniają oczekiwania dotyczące wydajności, oraz jakie najlepsze praktyki warto wziąć pod uwagę przy wdrażaniu tej techniki.

Informacje o testach porównawczych oprogramowania

What is automated testing?

Testy porównawcze oprogramowania polegają na pomiarze wydajności aplikacji w odniesieniu do wcześniej zdefiniowanego zestawu standardów lub wzorców porównawczych. Różnią się one od standardowych testów wydajnościowych, które mają jedynie na celu sprawdzenie, czy oprogramowanie spełnia podstawowe wymagania funkcjonalne.

Wzorcami porównawczymi mogą być standardy branżowe, wcześniej ustalone cele wewnętrzne, a nawet wydajność konkurencyjnych aplikacji. Te porównania pozwalają zespołom tworzącym oprogramowanie identyfikować obszary wymagające poprawy i dbać, aby oprogramowanie spełniało pożądane standardy jakościowe.

Chodzi o uzyskanie obiektywnej miary wydajności, która pomaga programistom zrozumieć, jak oprogramowanie zachowuje się w różnych warunkach. Rozpoznanie wad i potencjalnych wąskich gardeł jest pierwszym krokiem do zapewnienia użytkownikom bezproblemowej obsługi.

Typy testów porównawczych oprogramowania

W czasach, gdy normą było ręczne testowanie, firmy programistyczne często zatrudniały zespół QA w pełnym wymiarze godzin. Zespół ten przygotowywał zbiór „planów testów” lub listy kontrolne, w ramach których krok po kroku zapewniano, że dana funkcja opracowywanego oprogramowania działa zgodnie z oczekiwaniami. Zespół QA ręcznie używał tych list kontrolnych przy każdej aktualizacji projektu oprogramowania lub zmianie w jego ramach, a następnie przekazywał wyniki planów testów zespołowi inżynierów do przeglądu i dalszych prac w celu rozwiązania problemów.

Proces ten był powolny, kosztowny i podatny na błędy. Zautomatyzowane testowanie przynosi ogromne korzyści w zakresie wydajności zespołu i zwrotu z inwestycji w zespoły QA.

Automatyzacja procesu testowania przenosi odpowiedzialność za projekt na zespół inżynierów. Plany testów są opracowywane równolegle z regularnym rozwojem funkcji uwzględnionych w harmonogramie projektu, a następnie realizowane automatycznie przez narzędzia do ciągłej integracji oprogramowania. Model zautomatyzowanego testowania sprzyja zmniejszeniu wielkości zespołu QA i pozwala jego członkom skupić się na najistotniejszych funkcjach.

Programiści mogą rozważyć zastosowanie szeregu wzorców porównawczych do pomiaru wydajności oprogramowania podczas jego opracowywania, w zależności od funkcjonalności, której udoskonalenie najbardziej ich interesuje. Przyjrzyjmy się czterem najpopularniejszym obszarom testów porównawczych:

Testy porównawcze wydajności

Testy porównawcze wydajności mierzą szybkość działania i wydajność aplikacji w typowych scenariuszach użytkowania. Symulując rzeczywiste scenariusze i interakcje użytkowników, programiści mogą gromadzić cenne dane na temat czasów reakcji, szybkości przetwarzania transakcji i wykorzystania zasobów (procesor, pamięć, operacje we/wy dysku). Te informacje pomagają wskazać obszary, w których może być konieczna optymalizacja kodu lub ulepszenie sprzętu w celu wyeliminowania problemów z wydajnością.

Testy porównawcze obciążenia

Testy porównawcze obciążenia oceniają, jak oprogramowanie działa przy różnych obciążeniach generowanych przez użytkowników. Symulując jednoczesne korzystanie z aplikacji przez wielu użytkowników, programiści mogą wykrywać wąskie gardła wydajności, które mogą pojawić się, gdy aplikacja jest maksymalnie obciążona. Ma to kluczowe znaczenie dla aplikacji, w których spodziewany jest duży ruch lub sezonowe okresy szczytowego użycia. Analiza wskaźników, takich jak czasy odpowiedzi, częstotliwość błędów i przepustowość, w różnych warunkach obciążenia, pomaga zapewnić, że oprogramowanie poradzi sobie z oczekiwanym zapotrzebowaniem ze strony użytkowników.

Poznaj rozwiązanie

Tworzenie i obsługa oprogramowania za pomocą Open DevOps

Materiały pokrewne

Zautomatyzowane testowanie na potrzeby DevOps

Testy porównawcze przeciążenia

Testy porównawcze przeciążenia idą dalej, gdyż celowo przekraczają normalną wydajność operacyjną oprogramowania. Pomaga to ustalić punkt krytyczny aplikacji i ocenić jej możliwość szybkiego powrotu do normalnego działania po awarii. Sprawdzając zachowanie systemu w ekstremalnych warunkach, programiści mogą wdrożyć środki poprawiające jego stabilność i zapobiegające krytycznym awariom w środowiskach produkcyjnych.

Testy porównawcze skalowalności

Testy porównawcze obciążenia sprawdzają zachowanie oprogramowania w określonych warunkach, natomiast testy porównawcze skalowalności oceniają jego stabilność w przypadku zmiany tych warunków. Może to dotyczyć zwiększenia liczby użytkowników albo wolumenu danych lub transakcji. Wszystkie firmy nastawiają się na rozwój, a administracje państwowe muszą przygotować swoje platformy do warunków masowego użytkowania. Poza tymi obszarami jest także wiele innych aplikacji o dużym potencjale wzrostu, na przykład gry online dla wielu użytkowników, sieci społecznościowe i aplikacje IOT.

Zasada działania testów porównawczych oprogramowania

1. Testy kompleksowe

Testy porównawcze zazwyczaj obejmują następujące kroki:

- Planowanie: Zdefiniuj cele testu, określ kluczowe wskaźniki wydajności (KPI) i ustal wzorce porównawcze. KPI różnią się od wzorców porównawczych tym, że są wyłącznie wewnętrznymi miarami tego, jakie wyniki ma osiągnąć zespół.

- Konfiguracja środowiska testowego: Utwórz kontrolowane środowisko przypominające środowisko produkcyjne. Środowisko produkcyjne nie nadaje się najlepiej do testowania, ponieważ zawiera rzeczywiste dane użytkowników, które podczas testów mogą zostać nieumyślnie zmienione lub narażone na luki w zabezpieczeniach.

- Wykonanie testów: Przeprowadź testy porównawcze przy użyciu odpowiednich narzędzi i zbierz dane dotyczące wydajności. Wybór narzędzi zależy od testowanego wskaźnika, takiego jak kryteria funkcjonalności, wydajności, bezpieczeństwa czy użyteczności.

- Analiza: przeanalizuj wyniki i porównaj je z ustalonymi wzorcami.

- Raportowanie: udokumentuj wyniki i przekaż je zespołowi programistycznemu.

Do testów porównawczych oprogramowania zazwyczaj stosuje się narzędzia, takie jak JMeter, LoadRunner czy Gatling. Kluczowe wskaźniki zbierane podczas tych testów to na przykład czasy odpowiedzi, przepustowość, częstotliwość błędów i wykorzystanie zasobów.

Zalety testów porównawczych oprogramowania

Oprócz ogólnych zalet związanych z pomiarem wydajności, przepustowości i skalowalności tworzonego oprogramowania testy porównawcze oferują także kilka bardziej konkretnych korzyści:

Zapewnianie niezawodności oprogramowania

Programiści mogą proaktywnie identyfikować i rozwiązywać potencjalne problemy, zanim zaczną być odczuwane przez użytkowników. Efektem jest poprawa stabilności, skrócenie czasu przestojów i zwiększenie zadowolenia użytkowników. Regularne testy porównawcze pomagają zbudować pewność co do niezawodności oprogramowania na przestrzeni czasu.

Identyfikacja wąskich gardeł i problemów z wydajnością

Testy porównawcze mogą pomóc odkryć ukryte wąskie gardła związane z wydajnością, które mogą nie być widoczne, jeśli system lub jego komponenty są testowane w izolacji. Wynika to z faktu, że regularne testowanie przedkłada poprawność nad wydajność lub efektywność. Wąskie gardła wykrywane przez testy porównawcze mogą występować w kodzie aplikacji, zapytaniach bazy danych, infrastrukturze sieciowej lub ograniczeniach sprzętowych. Poprzez zidentyfikowanie tych ograniczeń programiści mogą zoptymalizować odpowiednie obszary, aby poprawić ogólną wydajność systemu.

Podstawa do przyszłych ulepszeń

Wyniki testów porównawczych służą za cenny punkt odniesienia podczas pomiaru wpływu przyszłych zmian w oprogramowaniu. Po dodaniu nowych funkcji lub zoptymalizowaniu kodu programiści mogą porównać wyniki nowego testu porównawczego z punktem odniesienia, aby ocenić skutki wprowadzonych zmian. Dzięki temu mają pewność, że aktualizacje i ulepszenia faktycznie poprawiają wydajność i nie tworzą przy okazji nowych problemów.

Najlepsze praktyki w zakresie przeprowadzania testów porównawczych oprogramowania

Jeśli celem testów porównawczych jest zapewnienie prawidłowego działania oprogramowania, warto zadbać o ich odpowiednie przeprowadzenie. Oto kilka porad dotyczących udanego przebiegu testów porównawczych:

- Określenie jasnych celów: wyraźnie określ cele testów porównawczych i konkretne wskaźniki wydajności, które mają być mierzone.

- Użycie odpowiednich narzędzi: Wybierz odpowiednie narzędzia i upewnij się, że są odpowiednio skalibrowane oraz skonfigurowane do danego zadania. Przy ich doborze warto uwzględnić także czynniki, takie jak typ aplikacji, oczekiwane obciążenie i pożądane wskaźniki.

- Zwrócenie uwagi na środowisko testowe: środowisko testowe powinno dokładnie odzwierciedlać środowisko produkcyjne, aby umożliwić uzyskanie poprawnych i wiarygodnych wyników.

- Regularne aktualizowanie testów porównawczych: Wraz z rozwojem oprogramowania powinny ewoluować także testy porównawcze. Regularnie je aktualizuj, aby odzwierciedlały zmiany oczekiwań użytkowników, standardy branżowe i postęp techniczny.

- Wielokrotne powtarzanie testów: Powtarzanie pozwoli wykryć wahania wydajności i zapewnić bardziej reprezentatywny zestaw danych. Dobrą praktyką jest również przeprowadzanie testów w różnych warunkach (np. różne obciążenia użytkowników, różne pory dnia), aby zrozumieć, jak zmienia się wydajność.

- Dokładna analiza wyników: Staranne dobranie najodpowiedniejszej metody statystycznej i technik identyfikacji korelacji oraz zwrócenie uwagi na istotne czynniki pomoże wskazać najcenniejsze analizy umożliwiające kierowanie działaniami w zakresie optymalizacji wydajności. Jest to kolejny przypadek, gdzie konieczny jest wybór odpowiednich narzędzi, takich jak aplikacja internetowa do zautomatyzowanej analizy danych i raportowania lub narzędzia do śledzenia trendów wydajności na przestrzeni czasu.

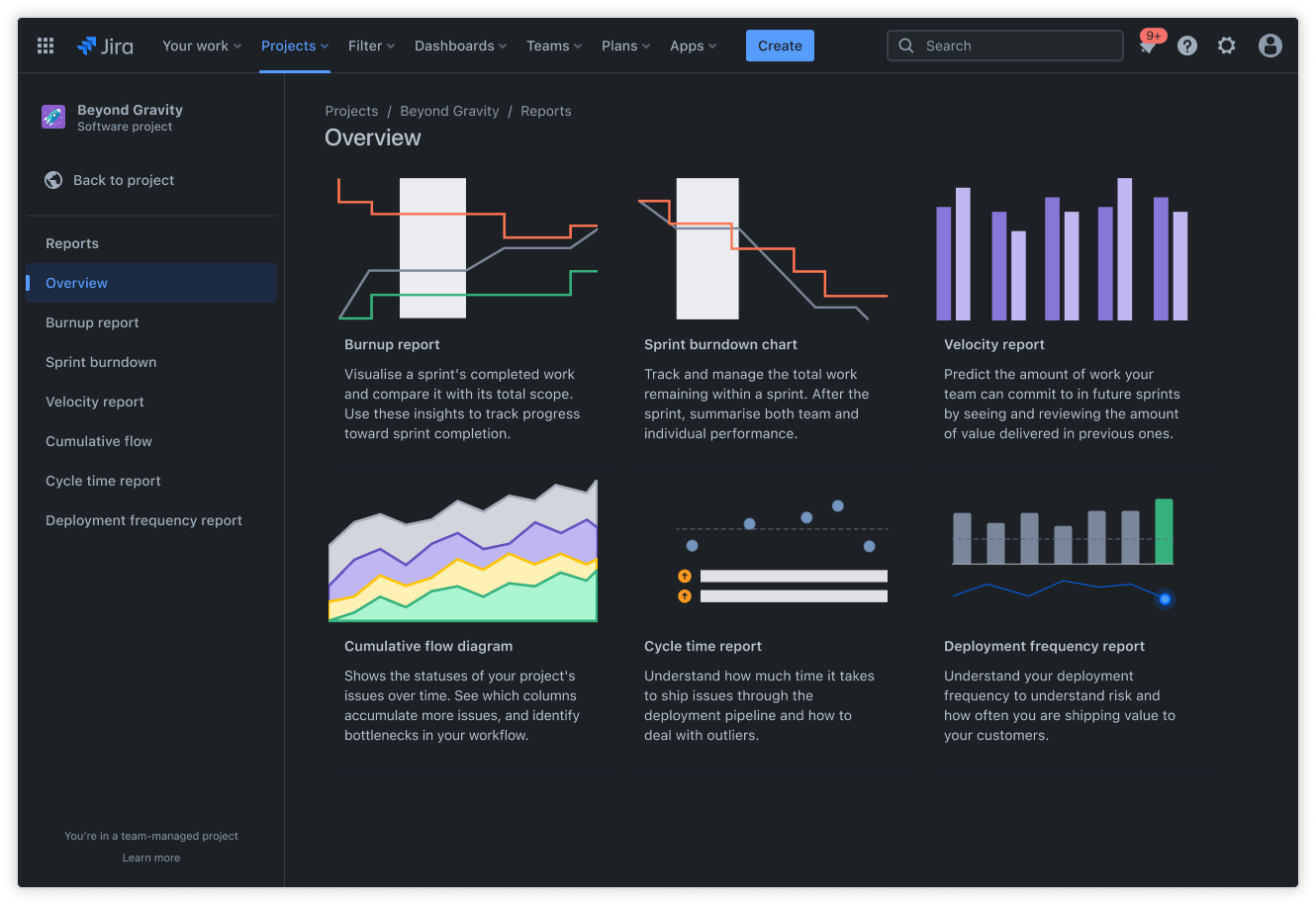

Platforma zarządzania procesami, taka jak Jira, może odgrywać kluczową rolę w zarządzaniu testami porównawczymi i ich śledzeniu, zwłaszcza jeśli produkcja jest zautomatyzowana w ramach modelu ciągłego wdrażania (CD). Oto cechy wyróżniające Jirę pod tym względem:

Backlog w Jirze: użyj backlogu, aby planować działania związane z testami porównawczymi oraz ustalać ich priorytet w kontekście innych zadań programistycznych.

Raporty w Jirze: Skorzystaj z gotowych raportów w Jirze, aby pomóc zespołom śledzić postępy projektów, wizualizować trendy i przewidywać przyszłe wyniki. Te raporty mogą służyć także do udostępniania wyników interesariuszom.

Użyj darmowego szablon raportu z projektu

Dzięki integracji testów porównawczych z Jirą zespoły mogą uczynić optymalizację wydajności integralną częścią procesu programistycznego, co w rezultacie prowadzi do lepszej jakości oprogramowania.

Typowe wyzwania w przypadku testów porównawczych oprogramowania

Powyższa lista najlepszych praktyk podkreśla znaczenie zachowania ostrożności podczas opracowywania programu testów porównawczych i zarządzania nim. Oto kilka typowych pułapek związanych z testami porównawczymi oprogramowania i sposoby radzenia sobie z nimi:

- Ograniczenia zasobów: Testy porównawcze mogą wymagać dużej ilości zasobów sprzętowych i programowych. Jedną z zalet Jiry jest to, że ma ona wbudowane oprogramowanie do zarządzania zasobami, które pozwala zespołom uwalniać i przydzielać niezbędne zasoby na potrzeby testowania.

- Obsługa danych testowych: Tworzenie realistycznych danych testowych i zarządzanie nimi może być czasochłonne i skomplikowane. Programiści mogą użyć narzędzi zarządzania danymi testowymi (TDM) do generowania i maskowania danych testowych oraz zarządzania nimi. Te narzędzia pozwalają wyodrębniać podzbiory danych z produkcyjnych baz danych, stosować maskowanie w celu ochrony prywatności danych lub tworzyć dane syntetyczne, które naśladują właściwości statystyczne oryginalnych zestawów danych.

- Zmienność w środowiskach testowych: dopasowanie środowiska testowego do środowiska produkcyjnego bywa skomplikowane, a niewielkie różnice mogą prowadzić do niedokładnych wyników. I znów Jira oferuje rozwiązanie. Utworzenie systemu zarządzania środowiskiem testowym w Jirze pomaga programistom śledzić środowiska testowe i zarządzać nimi, zapewniając spójność i ograniczając zmienność.

Integracja testów porównawczych oprogramowania w Jirze w celu usprawnienia procesu rozwoju oprogramowania

Oprócz wykorzystywania Jiry do określonych zadań, takich jak zarządzanie zasobami i zarządzanie środowiskiem testowym, platforma ma kilka funkcji, które można zintegrować z przepływem pracy w testach porównawczych. Oto kilka obszarów, w których integracja Jira może pomóc usprawnić cały proces:

- Śledzenie trendów wydajności: funkcje Zgłoszenia i Pola niestandardowe w Jirze pozwalają zespołom oznaczać i rejestrować błędy, ulepszenia i zadania związane z wydajnością. Są to podstawowe wymagania dotyczące monitorowania wskaźników wydajności w czasie, identyfikacji obszarów wymagających poprawy, śledzenia korygowania anomalii i pomiaru wpływu optymalizacji.

- Zarządzanie działaniami z zakresu analizy porównawczej: w Jirze zespoły mogą tworzyć plany przepływów pracy Agile oraz tablice rozwoju oprogramowania Agile w celu ustalenia priorytetów i przechodzenia między określonymi fazami procesu testów porównawczych.

- Efektywna współpraca: ułatw komunikację i współpracę między programistami, testerami i interesariuszami dotyczącą problemów i ulepszeń związanych z wydajnością. Kluczowym aspektem tej funkcji jest zakres Jiry służący generowaniu niestandardowych raportów w celu wizualizacji danych dotyczących wydajności, śledzenia postępów i komunikowania wyników. Równolegle funkcja Zgłoszenia łączy powiadomienia o testach wydajności z powiązanymi zadaniami programistycznymi, błędami lub historyjkami użytkowników. Ponadto funkcja Załączniki wykorzystuje scentralizowany dostęp w celu uwzględnienia wyników testów wydajności, raportów i dokumentów analitycznych z odpowiednimi zgłoszeniami.

- Backlog: struktura backlogu Jiry jest warta ciągłego przypominania, ponieważ ułatwia otagowywanie zadań i ustalanie priorytetów w testach porównawczych. Tworząc historyjki użytkowników specjalnie do testów wydajności, zespoły mogą wykorzystać funkcje backlogu do szczegółowego planowania, tworzenia harmonogramów sprintów i śledzenia postępów. Jest to szczególnie przydatne dla zespołów, które lubią pracować iteracyjnie, ponieważ pozwala im planować wszystkie zadania w backlogu i wizualizować zakres projektu.

Dzięki integracji darmowych testów porównawczych oprogramowania z Jirą zespoły programistyczne mogą wspierać kulturę optymalizacji wydajności, co poprawia jakość oprogramowania, zadowolenie użytkowników i wydajność procesu rozwoju.

Udostępnij ten artykuł

Następny temat

Zalecane lektury

Dodaj te zasoby do zakładek, aby dowiedzieć się więcej na temat rodzajów zespołów DevOps lub otrzymywać aktualności na temat metodyki DevOps w Atlassian.

Społeczność DevOps

Przeczytaj blog