¿Qué son las pruebas comparativas de software?

No es lo mismo desarrollar software que funcione que software que funcione bien. A fin de asegurarse de que su producto entre en esta última categoría, los desarrolladores suelen recurrir a las pruebas comparativas.

Esta metodología se distingue entre los distintos tipos de pruebas de software por su capacidad para identificar en qué punto se encuentra un proyecto en relación con las soluciones de la competencia y qué aspectos deben mejorarse.

En este artículo, se explica cómo las pruebas comparativas permiten conseguir este objetivo, cómo ayudan a garantizar que las aplicaciones de software cumplan las expectativas de rendimiento y qué prácticas recomendadas se deben considerar a la hora de aplicar esta técnica.

Pruebas comparativas de software

¿Qué son las pruebas automatizadas?

Las pruebas comparativas de software miden el rendimiento de una aplicación de software según un conjunto predefinido de estándares o puntos de referencia. Esto difiere de las pruebas de rendimiento estándar, que solo tienen como objetivo comprobar que el software cumpla sus requisitos funcionales básicos.

Los puntos de referencia pueden ser los estándares del sector, los objetivos internos preestablecidos o incluso el rendimiento de las aplicaciones de la competencia. Estas comparaciones permiten a los equipos de desarrollo de software identificar las áreas de mejora y garantizar que el software cumpla con los estándares de calidad deseados.

El objetivo es proporcionar una medida objetiva del rendimiento que ayude a los desarrolladores a entender cómo se comporta el software en diferentes condiciones. Identificar los defectos y los posibles cuellos de botella de esta manera es el primer paso para ofrecer una experiencia de usuario perfecta.

Tipos de pruebas comparativas de software

En la época en la que realizar pruebas manuales era lo normal, era habitual que las empresas de software contrataran a un equipo de control de calidad a tiempo completo que se encargara de desarrollar una colección de “planes de pruebas”, o checklists paso a paso, que afirmaban que una función de un proyecto de software se comportaba según lo previsto. Dicho equipo ejecutaba de forma manual estas checklists cada vez que se introducía una actualización nueva o un cambio en el proyecto de software y, a continuación, devolvía los resultados de los planes de pruebas al equipo de ingeniería para que los revisara y desarrollara con el fin de solucionar las incidencias.

Este proceso era lento, caro y propenso a errores. Las pruebas automatizadas aportan enormes beneficios a la eficiencia del equipo y al ROI de los equipos de control de calidad.

Además, ponen la responsabilidad de la propiedad en manos del equipo de ingeniería. Los planes de pruebas se desarrollan junto con el desarrollo periódico de funciones de la hoja de ruta y, a continuación, se ejecutan automáticamente mediante herramientas de integración continua de software. Las pruebas automatizadas favorecen la reducción del tamaño del equipo de control de calidad y permiten que este se centre en funciones más delicadas.

Los desarrolladores pueden considerar una serie de puntos de referencia para medir el rendimiento del software durante su desarrollo, según la funcionalidad que más les interese perfeccionar. Veamos las cuatro áreas más comunes de las pruebas comparativas:

Puntos de referencia de rendimiento

Las pruebas comparativas de rendimiento miden la velocidad y la eficacia de una aplicación de software en las situaciones de uso típicas. Al simular situaciones del mundo real e interacciones de los usuarios, los desarrolladores pueden recopilar datos valiosos sobre los tiempos de respuesta, la velocidad de procesamiento de las transacciones y el uso de los recursos (CPU, memoria o E/S de disco). Esta información ayuda a identificar las áreas en las que podría requerirse la optimización del código o actualizaciones del hardware para erradicar problemas de rendimiento.

Puntos de referencia de carga

Los puntos de referencia de carga evalúan el rendimiento del software en diferentes cargas de usuarios. Mediante la simulación de varios usuarios simultáneos, los desarrolladores pueden identificar los cuellos de botella de rendimiento que pueden surgir cuando la aplicación está al máximo de su capacidad. Esto es crucial para las aplicaciones en las que se espera mucho tráfico o que están sujetas a picos de uso estacionales. Analizar métricas como los tiempos de respuesta, las tasas de errores y el rendimiento en diferentes condiciones de carga ayuda a garantizar que el software pueda gestionar la demanda esperada de los usuarios.

Ver la solución

Desarrolla y pon en marcha software con Open DevOps

Material relacionado

Pruebas automatizadas para DevOps

Puntos de referencia de estrés

Las pruebas de estrés van un paso más allá de las pruebas de carga al forzar deliberadamente el software por encima de su capacidad operativa normal. Esto ayuda a descubrir el punto de ruptura de la aplicación y a evaluar su capacidad para recuperarse de los fallos. Al identificar cómo se comporta el sistema en condiciones extremas, los desarrolladores pueden aplicar medidas para mejorar su estabilidad y evitar fallos catastróficos en entornos de producción.

Puntos de referencia de escalabilidad

Mientras que los puntos de referencia de carga ponen a prueba el comportamiento del software en condiciones específicas, los puntos de referencia de escalabilidad evalúa la capacidad de transición entre esas condiciones. Esto podría implicar aumentar el número de usuarios, el volumen de datos o el volumen de transacciones. Todas las empresas aspiran a crecer y los gobiernos deben preparar sus plataformas para una adopción masiva. Aun así, fuera de esos ámbitos, existen muchas otras aplicaciones con un alto potencial de crecimiento, como juegos en línea multiusuario, redes sociales y aplicaciones de IoT.

Funcionamiento de las pruebas comparativas de software

1. Pruebas de extremo a extremo

Las pruebas comparativas suelen incluir los siguientes pasos:

- Planificación: define los objetivos de la prueba, identifica los indicadores clave de rendimiento (KPI) y establece los puntos de referencia. Los KPI se diferencian de los puntos de referencia en que son medidas estrictamente internas del desempeño del equipo.

- Configuración del entorno de prueba: crea un entorno controlado similar al entorno de producción. El entorno de producción no es el ideal para las pruebas, ya que implica datos de usuario reales que podrían cambiarse inadvertidamente o quedar expuestos a vulnerabilidades durante las pruebas.

- Ejecución de pruebas: ejecuta las pruebas comparativas con las herramientas adecuadas y recopila datos de rendimiento. La elección de las herramientas depende de la métrica que se esté probando, como los criterios funcionales, de rendimiento, de seguridad o de usabilidad.

- Análisis: analiza los resultados y compáralos con los puntos de referencia establecidos.

- Informes: documenta las conclusiones y comunícaselas al equipo de desarrollo.

Para las pruebas comparativas de software, se suelen utilizar herramientas como JMeter, LoadRunner y Gatling. Las principales métricas recopiladas durante estas pruebas son los tiempos de respuesta, el rendimiento, las tasas de error y el uso de los recursos.

Venatajas de las pruebas comparativas de software

Dentro del beneficio general de medir el rendimiento, la capacidad y la escalabilidad del software en desarrollo, las pruebas comparativas ofrecen varias ventajas más específicas:

Garantía de la fiabilidad del software

Los desarrolladores pueden identificar y abordar de forma proactiva los posibles problemas antes de que afecten a los usuarios. Esto se traduce en una mejora de la estabilidad, una reducción del tiempo de inactividad y un aumento de la satisfacción de los usuarios. La evaluación comparativa periódica ayuda a generar confianza en la capacidad del software de funcionar de forma constante a lo largo del tiempo.

Identificación de cuellos de botella y problemas de rendimiento

Las pruebas comparativas pueden ayudar a descubrir cuellos de botella ocultos en el rendimiento que pueden no resultar evidentes si el sistema o sus componentes se prueban de forma aislada. Esto se debe a que, en las pruebas periódicas, se prioriza la corrección por encima del rendimiento o la eficiencia. Los cuellos de botella que exponen las pruebas comparativas podrían estar en el código de la aplicación, las consultas a la base de datos, la infraestructura de red o las limitaciones de hardware. Al identificar estas limitaciones, los desarrolladores pueden optimizar las áreas afectadas para mejorar el rendimiento general del sistema.

Base para futuras mejoras

Los resultados de las pruebas comparativas sirven como una valiosa base para medir el impacto de los cambios futuros en el software. Cuando se añadan nuevas funciones o se optimice el código, los desarrolladores podrán comparar los nuevos resultados con los de la referencia para evaluar el impacto de los cambios. Esto ayuda a garantizar que las actualizaciones y mejoras incrementen el rendimiento en lugar de introducir inadvertidamente nuevos problemas.

Prácticas recomendadas para realizar pruebas comparativas de software

Si el objetivo de las pruebas comparativas es garantizar que el software funcione bien, vale la pena asegurarse de que las pruebas en sí mismas se lleven a cabo correctamente. Aquí tienes algunos consejos para que el proceso de pruebas comparativas sea eficaz:

- Define objetivos claros: describe claramente los objetivos de las pruebas comparativas y las métricas de rendimiento específicas que se van a medir.

- Usa las herramientas adecuadas: selecciona las herramientas correctas para el trabajo y asegúrate de que estén correctamente calibradas y configuradas para la tarea en cuestión. Factores como el tipo de aplicación, la carga esperada y las métricas deseadas también determinarán cuál es la mejor herramienta de prueba.

- Presta atención al entorno de prueba: asegúrate de que el entorno de prueba refleje fielmente el entorno de producción para obtener resultados precisos y fiables.

- Actualiza los puntos de referencia con regularidad: a medida que el software evolucione, también deberían hacerlo los puntos de referencia. Actualiza periódicamente los puntos de referencia para reflejar los cambios en las expectativas de los usuarios, los estándares del sector y los avances tecnológicos.

- Repite las pruebas varias veces: la repetición compensará las variaciones de rendimiento y proporcionará un conjunto de datos más representativo. También es recomendable realizar pruebas en diferentes condiciones (por ejemplo, diferentes cargas de usuario u horas del día) para entender cómo cambia el rendimiento.

- Analiza los resultados con precisión: elegir detenidamente el método estadístico más adecuado y las técnicas para identificar las correlaciones, así como prestar atención a los factores relevantes, ayudará a identificar la información más valiosa para orientar los esfuerzos de optimización del rendimiento. Es otro caso en el que hay que elegir las herramientas adecuadas, como una aplicación web para el análisis y la elaboración de informes de datos automatizados o herramientas para hacer un seguimiento de las tendencias de rendimiento a lo largo del tiempo.

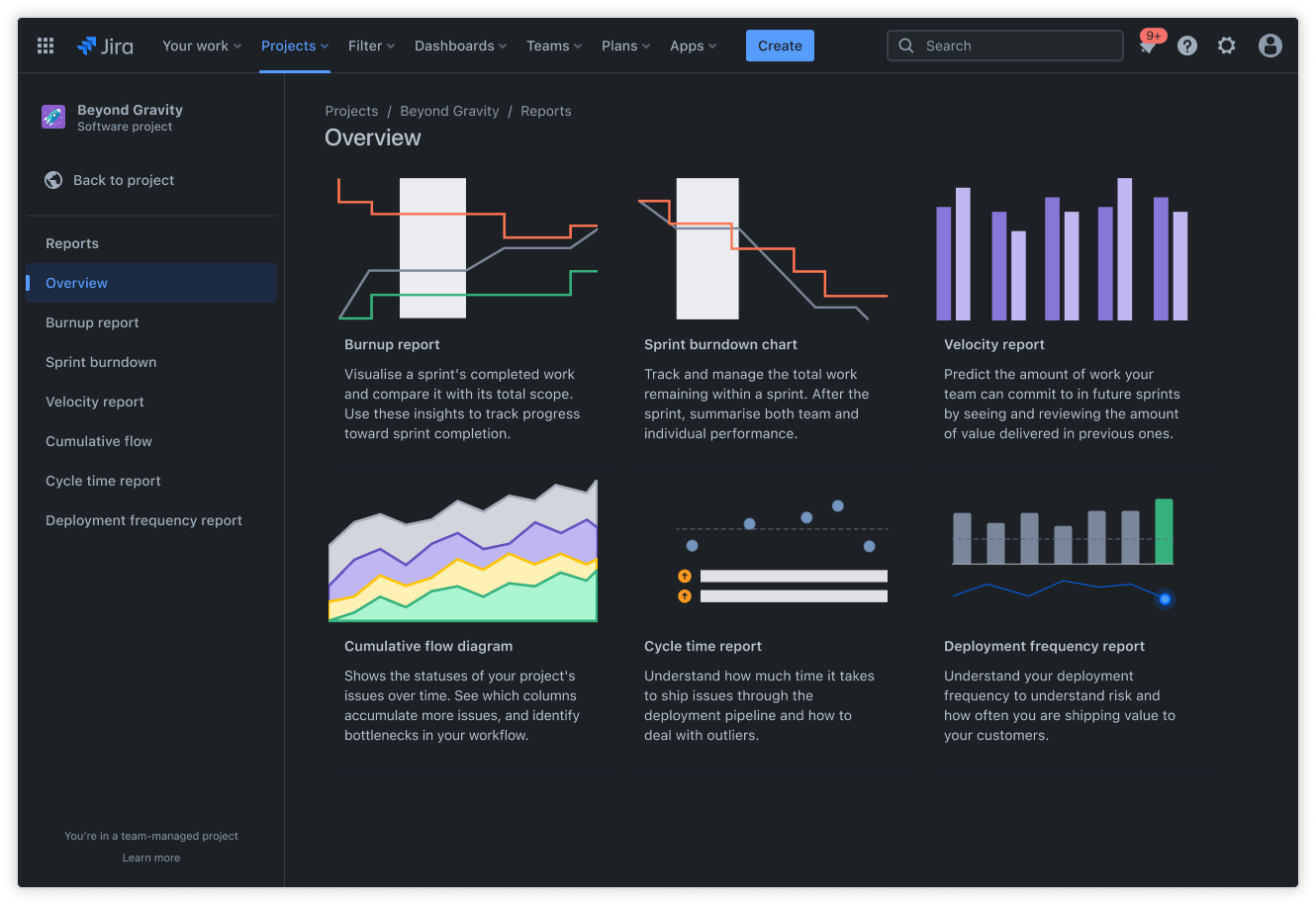

Una plataforma de gestión de procesos como Jira puede ser fundamental para gestionar y hacer un seguimiento de las pruebas comparativas, especialmente si la producción se automatiza según un modelo de implementación continua (CD). Estas son las características que hacen que Jira destaque en este sentido:

Backlog de Jira: utiliza el backlog para planificar y priorizar las actividades de pruebas comparativas junto con otras tareas de desarrollo.

Informes de Jira: usa los informes listos para usar de Jira para ayudar a los equipos a hacer un seguimiento del progreso de los proyectos, visualizar las tendencias y predecir el rendimiento futuro. Estos informes también se pueden utilizar para comunicar los resultados a las partes interesadas.

Usar plantilla de informe de proyecto gratuita

Al integrar las pruebas comparativas en Jira, los equipos pueden asegurarse de que la optimización del rendimiento sea una parte integral del proceso de desarrollo, lo que se traduce en una mejor calidad del software.

Retos comunes de las pruebas comparativas de software

En la lista de prácticas recomendadas anterior, se destaca la importancia de actuar con cautela a la hora de configurar y gestionar un programa de pruebas comparativas. Estos son algunos de los errores más comunes de las pruebas comparativas de software y cómo solucionarlos:

- Límite de recursos: las pruebas comparativas pueden consumir muchos recursos y requerir importantes recursos de hardware y software. Una de las ventajas de usar Jira es que incorpora un software de gestión de recursos que ayuda a los equipos a liberar y asignar los recursos necesarios para las pruebas.

- Mantenimiento de los datos de las pruebas: crear y gestionar datos de prueba realistas puede ser complicado y llevar mucho tiempo. Los desarrolladores pueden utilizar las herramientas de gestión de datos de prueba (TDM) para generar, enmascarar y gestionar los datos de las pruebas. Estas herramientas pueden extraer subconjuntos de datos de las bases de datos de producción, utilizar el enmascaramiento para proteger la privacidad de los datos o crear datos sintéticos que imiten las propiedades estadísticas de los conjuntos de datos originales.

- Variabilidad en los entornos de pruebas: alinear el entorno de pruebas con el entorno de producción puede resultar complicado y las pequeñas diferencias pueden llevar a resultados imprecisos. De nuevo, Jira tiene la solución. Crear un sistema de gestión de entornos de pruebas en Jira ayuda a los desarrolladores a supervisar y gestionar los entornos de pruebas, garantizando la homogeneidad y reduciendo la variabilidad.

Integra las pruebas de software de referencia en Jira para mejorar el desarrollo de software

Además de usar Jira para tareas específicas, como la gestión de recursos y la gestión del entorno de pruebas, la plataforma tiene varias funciones que se pueden integrar en el flujo de trabajo de las pruebas de referencia. La integración de Jira puede agilizar todo el proceso en algunas de estas áreas:

- Supervisión de las tendencias de rendimiento: las funciones de actividades y campos personalizados de Jira permiten a los equipos marcar y registrar los errores, las mejoras y las tareas relacionadas con el rendimiento. Estos son los requisitos básicos para supervisar las métricas de rendimiento a lo largo del tiempo, identificar las áreas de mejora, supervisar la resolución de anomalías y medir el impacto de las optimizaciones.

- Gestión de las actividades de referencia: en Jira, los equipos pueden crear planes de flujo de trabajo ágil y tableros de desarrollo de software ágil para priorizar fases específicas del proceso de pruebas de referencia y hacer la transición entre ellas.

- Colaboración eficaz: facilitar la comunicación y la colaboración entre los desarrolladores, los evaluadores y las partes interesadas en relación con los problemas de rendimiento y las mejoras. Un aspecto clave de esta funcionalidad es la capacidad de Jira para generar informes personalizados donde visualizar los datos de rendimiento, supervisar el progreso y comunicar los hallazgos. Paralelamente, la función de actividades vincula las notificaciones de las pruebas de rendimiento con tareas de desarrollo, errores o historias de usuario relacionadas. Además, la función de archivos adjuntos aprovecha el acceso centralizado para incluir los resultados de las pruebas de rendimiento, los informes y los documentos de análisis con actividades relevantes.

- Backlog: se debe reiterar la estructura de backlog de Jira, ya que facilita el etiquetado y la priorización de las tareas en las pruebas de referencia. Al crear historias de usuario específicas para las pruebas de rendimiento, los equipos pueden aprovechar las funciones del backlog para planificar detalladamente, programar los sprints y supervisar el progreso. Esto resulta especialmente útil para los equipos que trabajan de forma iterativa, ya que pueden planificar todas las tareas en el backlog y visualizar el alcance del proyecto.

Al integrar las pruebas de software de referencia gratuitas en Jira, los equipos de desarrollo pueden fomentar una cultura de optimización del rendimiento, obteniendo como resultado un software de mayor calidad, una mayor satisfacción de los usuarios y un proceso de desarrollo más eficiente.

Compartir este artículo

Tema siguiente

Lecturas recomendadas

Consulta estos recursos para conocer los tipos de equipos de DevOps o para estar al tanto de las novedades sobre DevOps en Atlassian.

La comunidad de DevOps

Leer el blog